2020年,年中。

人类历史上最大的人工智能模型已经来到世间。

这只巨大的贝笔大声哭泣,告诉全世界:“我写的这篇文章差点就通过了图灵测试。”

第一次听说参数的人、第一次看实验结果的人、第一次口头计算生长速度的人,在互相确认了眼睛之后,一致的反应是:“哦,我可能疯了。不,是人工智能模型疯了。”

“我不仅会写短文,而且我写的文章太现实了,几乎可以欺骗人类,可以说我差一点就通过了图灵测试。”

如果没有最后两句半,你可能会误以为这是老师对文科尖子生的评价。

他也非常擅长科学,还可以辅导别人编程。

“以前是人类写程序,现在人类写人工智能算法,算法从数据中推导出程序,新的人工智能技术路线已经完成。”

渣男,看透红尘,敲木鱼,念出乔布斯名言:

做一个吃货,保持愚蠢。

无论如何,养老护理都交给了人工智能。这样的人工智能需要大量的资金和顶尖的技术。

科技大笔一挥,巨头微软拿走了一张价值数千万美元的支票,没有任何感谢。

据测算,即使使用市面上价格最低的GPU云计算(服务),也需要355年,成本超过3500万元。

大明宫总建筑师颜立本画完《步辇图》收起画笔,在献给太宗李世民的部下奏疏中题写了“十万劳力”。

千宫之宫将永留名号。

世界顶级的人工智能实验室耗资数千万美元。

三十一名研究人员徒手搭建了一只贝贝,看起来擅长从胸口压碎巨石。

桌椅动摇,万马哀嚎无声。

这个超大型人工智能模型被称为GPT-3。

早期的深度学习模型参数数量很少,就像每天放在桌子上看起来很可爱的乐高玩具。

在当今的深度学习模型中,参数数量挑战底层GPU并行技术,参数数量挑战底层基础。

例如,它也是乐高模型。 GPT-3可作为北京朝阳区三里屯优衣库门口的大型显示屏。

当然不是试衣服,而是和建筑比较。

知乎提问:“你怎么看待像大楼一样高的乐高模型?”

网友回复:“抬头看。”

如果不抬头,就只能看到自己的脚。正常的模型尺寸比例,Hulk GPT-3模型无法融入,必须重新绘制坐标轴的比例。

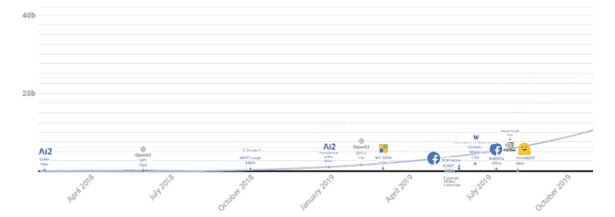

(原来的队列)

(GPT-3到达后排队)

人工智能超级模型GPT-3和浩克一样大。

经常观察可以治愈颈椎病。

Hulk GPT-3模型诞生于美国OpenAI实验室。

看到他们的论文在朋友圈疯传后,他们这样低调的科研团队一点也不骄傲。他们24小时就在办公室里旋转、跳跃、炫耀。

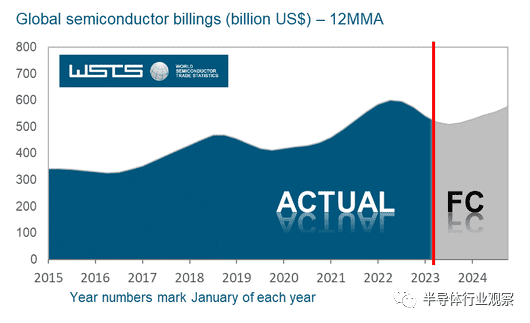

早在2019年,开放AI实验室就向前方发出了高能预警。

他们计算了自 2012 年以来模型使用的计算量,从 AlexNet 模型到 AlphaGo Zero 模型。 AlexNet 模型是冠军模型。 AlphaGo Zero模型是击败韩国围棋选手李世石的模型。它们都是人工智能模型。

参数指标非常可观,提升了30万倍。

“最大”的人工智能训练模型所使用的计算量呈指数级增长。

3.4个月后将翻倍。这是开放人工智能实验室的结论。

虽然它还没有成为“定律”,但很多人把它与“摩尔定律”相比较。

摩尔定律规定,芯片的性能翻倍的周期是18个月。 Open AI表示,人工智能训练模型所需计算量的倍增周期为3.4个月。

三个半月后,一台电脑已经不够了,所以我需要两台。快速算了一下,618大促的时候买了新机,双11大促的时候又得买新的。

对于人工智能研究来说,金钱是一个好仆人。

如果你不了解 Open AI,你就需要弥补。

在世界历史上,美国九年来首次使用国产火箭将宇航员从本国送入太空,私人航天公司首次进行载人发射。马斯克是震惊世界的公司的创始人。

Open AI是世界顶级的人工智能实验室,这个组织也得到了马斯克的支持。

平庸的人都是相似的。

疯狂的人以他们自己的方式疯狂。

人工智能算法模型可以有多大?

Hulk GPT-3模型给出了新的答案——1750亿个参数。

说实话,模式创新程度很难用单一指标来量化。模型复杂度与参数数量之间存在一定的关系。模型参数的数量决定了模型的大小。

浩克 GPT-3 型号是什么?

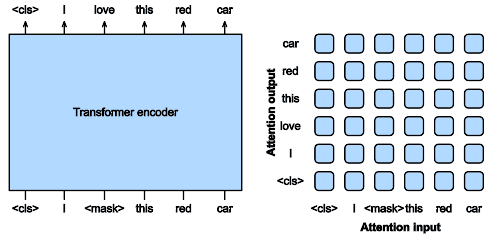

它是一个超大型自然语言处理模型,可将学习能力转移到同一领域的多个相关任务中。它不仅可以组词造句,还可以做阅读理解。听起来像是小学语文课的内容。

将此(训练前)模型与一名小学生进行比较,小学生已经可以完成一年级的中文作业、单词组合和造句。你接管并教授示范作业。不需要从头教,继续教二年级的题即可。

《语文》课本上熟悉的场景:“阅读全文,总结段落大意。”

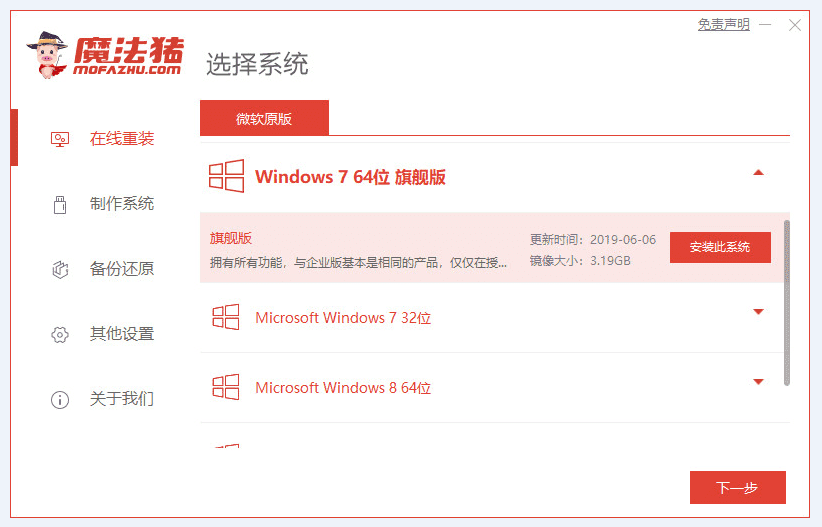

绿巨人GPT-3模型的“参数”值多少钱?我们来看看《福布斯·模型参数量排行榜》。

回顾2011年,冠军模型AlexNet拥有6000万个参数。

回顾过去两年,BERT模型非常流行,有3亿个参数。

Hulk GPT-3 模型的哥哥 GPT-2 拥有 15 亿个参数。

NVIDIA 的 Megatron-BERT 拥有 80 亿个参数。

2020 年 2 月,微软图灵 NLP 拥有 170 亿个参数。

2020 年 6 月,Hulk GPT-3 拥有 1750 亿个参数。

小学数学老师告诉我们:Hulk GPT-3模型是稳赢的。

就连体育老师也得教这个。

这时,麦当劳说要人工智能,参数更多,欢乐更多。

为了理解模型的复杂性,我们需要回顾历史。

2015年,微软发明的用于图像识别的ResNet模型的训练过程包含大约2次浮点计算,模型包含数千万个参数。

2016年,百度发明的用于语音识别的DeepSpeech模型的训练过程包含约1亿次浮点计算,模型包含数亿个参数。

2017年,谷歌发明的机器翻译深度学习模型的训练过程包括大约100次子浮点计算,模型包含数十亿个参数。

微软、百度、谷歌仿佛走进了罗马斗兽场,眼里布满了血丝。

来吧,这不是那么血腥。看看科技巨头的年利润就知道了。人工智能本来就是贵族的游戏。哪个玩家没有几个实力雄厚的摇钱树。

2018年后,人工智能车型的消费水平已进入奢侈品俱乐部。驴牌教父起身鼓掌欢迎。

如果俱乐部有微信群,奢侈品牌负责人会依次“拍拍微软、百度、谷歌”。

这一幕,人工智能超模赋诗一首:

我想为我的训练感到自豪,

先花一亿吧。

表演一定很激烈,

花钱如流水。

人工智能算法模型“疯狂”增长的背后到底意味着什么?

针对这个问题,笔者采访了原微软亚洲研究院研究员、一流技术创始人袁锦辉博士。

袁博士用两种方式表达了这一点。

在第一个层面上,钱很重要。

袁锦辉博士表示:“人工智能模型的疯狂增长意味着人工智能的竞争已经进入军备竞赛级别。长期使用GPU集群的成本非常高。创建像GPT这样的超级模型的想法-3,也许有人能想到,但并不是每个团队都有钱去验证这个想法,除了Google之外,很多公司都没有财力来训练BERT-Large模型,而实现这个想法需要极其高工程能力。”

有钱人的生活就是这样,朴实无华,乏味。要训练非常大的 GPT-3 模型,必须使用非常大的 GPU机器学习集群。训练一个人工智能模型的成本高达数千万美元,一颗卫星的制造成本被马斯克压低到了50万美元以下。人工智能模型比卫星更昂贵。

有钱人的生活多了一点,有钱人也要勤快。

第二个层次不仅仅是有钱,技术也很重要。

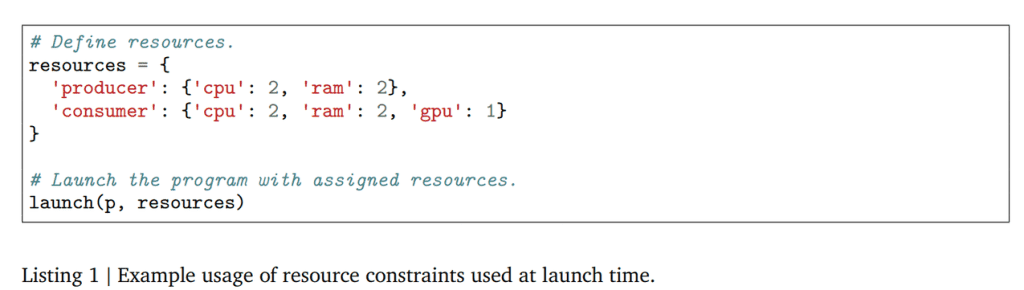

在袁锦辉看来,人工智能的大型模型运行在大规模GPU(或TPU)集群上。训练需要分布式深度学习框架才能在可接受的时间内看到改进效果。大型模型的训练如果没有分布式、深度学习框架的支持,即使你可以投入大量资金构建大规模的GPU集群也无济于事。模型和算力增长如此之快,如果深度学习框架不随之发展,就会限制算法研究的水平和迭代的速度。

对深度学习框架和人工智能模型的要求是,除了努力进取的我之外,还有也在努力进取的你。

深度学习框架呼唤技术创新。如果你继续遵守规则,你就会被“抛弃”。

狠不一定就是英雄,那么到底是什么技术如此重要呢?

一项可以打败“记忆墙”的技术。

记忆墙是什么?这个问题的答案是(hen)点(ke)和长(pu)。

早期的深度学习模型参数较小,一个GPU就够了。当参数数量变大,一个GPU不够用的时候,麻烦就开始了。当计算量相当大时,训练一个模型十天半是常有的事,分布的意义就显现出来了。由于一张 GPU 卡运行速度太慢,因此使用两张。一颗GPU芯片无法单独处理,因此需要多个GPU。对于一些深度学习应用来说,实现“线性加速比”是比较容易的,投入多少GPU资源就能获得多少倍的加速效果。

只要花钱,就可以减少计算时间,一切看起来都还不错。

然而,现实却扼住了你的喉咙,让你失去了“美丽”。

超大型模型的计算需求增加了数百或数千倍,不仅超越了任何类型芯片(GPU)单独的处理能力,而且即使你花钱买了数百或数千个GPU,对不起,加速比是非常低 。投入了一百倍的资源,却只能达到几倍的加速效果,甚至出现多GPU比单GPU慢的情况。

为什么?

首先,深度学习是一种接近“流式”的计算模型,计算粒度变得很小,很难完全运行硬件。

传统的大数据处理大多是批量计算,对整个数据进行扫描处理后得到结果。相比之下,深度学习训练基于随机梯度下降算法,这是流计算的典型特征,在扫描和处理每一小部分数据后调整和更新内部参数。

批量计算是一次带一锅,全部吃掉。流计算一次是一小碗。不给叔叔端饭,就不说话了。当你的嘴停止时,你的手也会停止。

一般来说,GPU 处理一小段数据只需要 100 毫秒,那么问题就变成了,“调度”算法能否准备好让 GPU 在 100 毫秒内处理下一小段数据。如果可能的话,GPU将保持在计算状态。否则,GPU 将间歇性暂停,这意味着设备利用率降低。

深度学习训练中计算任务的粒度非常小,通常在几十到几百毫秒的数量级。换句话说,工作要快。如果不赶紧分配新的任务,叔叔就休息了。

如果一直休息的话,工作肯定不会很快完成,工期会很长,而且会很匆忙。

另一方面,深度学习所使用的设备太强大了,无论是GPU还是AI芯片,计算速度都非常快。

单独的 GPU 芯片无法处理它,单独的 GPU 芯片也无法处理。通常CPU和GPU一起工作。 CPU负责任务调度和管理,GPU负责实现计算(密集)。这就是通常所说的异构计算(Heterogenous computing)。

但有一个新问题。 GPU的吞吐率非常高,可以是CPU的10倍以上,这意味着GPU可以更快地完成相同规模的计算任务。在进行GPU计算时,如果每次都从CPU或另一个GPU获取所需的数据,GPU也会变慢。

CPU就像一个吃饭慢的人。以前,一大锅他可以吃很久。 GPU就相当于一个吃饭速度很快的人。现在他每次只拿一小碗,一口吃下去。所以,把碗端上桌的速度非常关键。

CPU和GPU异口同声地说:

“记忆墙,你好吗?”

如果模型太大,需要将模型拆开。例如,神经网络的前几层在这个GPU上拆分,最后几层在另一个GPU上拆分,或者神经网络的某一层拆分到多个GPU上。

【怎么切是超纲题,暂时不(bu)答(hui)(wo)(ye)。 】

数据或模型拆分后,多个GPU需要频繁交互、相互通信。然而,整夜下雨,设备互联带宽达不到标准。没有实质性的改善。 PCIe在同机内部或用于多机互连的高速网络的传输带宽比GPU内部数据带宽低一两个数量级。

“内存墙”上的压力可以通过计算和数据传输之间的比率来衡量。理论上,计算机系统恰好有一个可以描述的概念,叫做算术强度。更随意地说,每字节的 flops 表示在一个字节的数据上发生的操作量。

只要计算量足够大,传输一个字节就能消耗足够的计算量,那么即使设备之间的传输带宽低于设备内部带宽,设备满载也是可能的。

此外,如果使用比GPU更快的芯片,处理一小段数据的时间将低于100毫秒,例如10毫秒。如果带宽保持不变,“部署”算法可以用10毫秒完成下一次计算。准备好?事实上,即使 GPU 的速度不是那么快(与 TPU 等专用芯片相比),当前主流的深度学习框架也不再具备模型并行性。

CPU和GPU,向天呐喊:

“记忆墙,你几岁了?”

“内存墙”带来巨大压力,如果处理不当,会导致设备利用率低、系统整体性能差。

理论上,训练框架和硬件平台的耦合度是比较高的。深度学习框架需要支持基于异构硬件的超大规模数据或模型的训练。分布式训练的实际性能很大程度上取决于底层硬件的效率。换句话说,解决这个问题需要一个深度学习框架。

记忆墙需要解决。没办法,是谁把深度学习框架放到了连接算法、连接芯片的位置呢?技术场上的卡位非常关键。

袁博士在“记忆墙”上用白漆画了一个大圆圈,并写了一个大字“拆”。

他认为这是深度学习框架应该解决的最重要的问题。生活中,钱可以解决大部分问题;然而,少数无法解决的问题才是根本问题。要训练非常大的人工智能模型,有钱可以买硬件,但需要技术来充分利用硬件。

原因很简单。

现实是非常残酷的。

“国内深度学习框架的发展水平并不落后,很多公司都开源了非常高水平的框架,这些够了吗?”

袁博士回答道:“如果直接使用现有的开源框架,确实不可能做大型模型,尤其是当参数数量达到GPT-3模型的水平时。

深度学习模型已经进入现阶段,大规模开发带来的问题单纯依靠开源深度学习框架已经变得有些困难。现有的开源分布式深度学习框架,无论使用多大的GPU集群,都需要很长的时间(几个月以上)才能完成训练,时间和人力成本极高。

弱者错失机会,强者创造机会。

“对开源版本的修改能否满足工业目的?”

袁博士回答道:“目前市面上的深度学习框架都有选择的空间,但目前在某些场景下(比如模型并行)不具备改造和定制的能力。比如Hulk GPT-3,直接就是不可能使用现有的开源深度学习框架。OpenAI实验室对开源框架进行了深度定制和优化,使得这个实验能够在可接受的时间内完整运行。”

大多数人只看到了模型昂贵的成本,而没有看到技术难度。

“单个芯片或单个服务器无法满足训练大型模型的需求。这就是所谓的Silicon Scaling的局限性。要解决这个问题,我们必须采用水平扩展的方法,通过高速将多个服务器连接在一起。互联形成计算资源池,利用深度学习框架等分布式软件与多个离散耦合的加速器高效协同工作,从而提高算力上限。”

袁博士继续解释道。

袁博士还特别介绍了解决这一问题的人才需求。他说:“深度学习框架改造很难,从团队角度来看,很难招到算法工程师,更难找到有理论背景的工程师计算机系统的人或者有足够的工程能力,懂算法。挖人并不能解决问题,算法工程师被挖了,算法的独创性就被夺走了。而深度学习框架几乎需要整个团队都用上.”

“超大型车型在今天并不是什么新鲜事,也不是今天才被注意到,但这种趋势一直都在。有先见之明的人可以更早地看到趋势。最先发现趋势、最先做好准备的人,就是最好的。”机会。”

“很多深度学习框架刚开始开发的时候并没有针对这个问题,或者没有看到这个问题。深度学习框架没有完成的任务就必须留给算法团队来检验算法公司技术团队的能力。” “对深度学习的理解,对框架的完善能力。市场上的情况是很少有公司能做到,但大多数公司做不到。”

聊了半天,我问了最后一个问题。

“GPT-3模型并没有用于企业业务,很多人认为它没什么用,它只是一个实验室小工具,它的科学意义是什么?”

他微笑着,用一贯的低沉声音说道:“GPT-3模型表明OpenAI实验室有科学见解。不是每个人都能想到朝那个方向探索。它们背后有一个科学理念。Think big的时候建模,有一种假设的方法论,当假设成立了,相应的科学问题就可以得到解决,在这种方法论的指导下,如果你勇于探索,绝对不会拍拍脑袋就花几千万。美元正在朝着超大型模型的方向冒着鲁莽的风险。”

袁锦辉将人工智能与人脑进行了比较。

他说:

“将人脑与我们现在的人工智能自然语言处理模型进行比较:人脑有100万亿个突触,比最大的人工智能模型大了三个数量级。这个人工智能模型被称为GPT-3。几乎通过了图灵测试。科研团队一直在寻找一种‘能正常工作’的聊天bot,这个模型让人们看到了突破。”

他在想,当真正实现万亿参数的神经网络时,今天人工智能和深度学习模型面临的困难是否会得到解决?机器人能够进行真正智能对话的那一天即将到来吗?

说这话的时候,他眼中闪过一抹精光。

在袁锦辉看来,这种里程碑式的突破通常需要优秀的团队才能实现。 OpenAI想到了,也做到了。它代表了世界在这方面的最高水平,探索了能力的边界,拓展了人类的想象力。就像一艘飞向宇宙最远的宇宙飞船,已经触及了人工智能模型参数增长的边界。

这种模式的出现就像航天工业中的“发射火箭”,成本高,工程要求高。他们的成功具有理论和工程意义。

人工智能的希望正在路上。

不管实验有多麻烦,

不管效果多么无效,

GPT-3模型一直是人类迈向“智能”的无尽阶梯上的第一级。

没有伟大的远见,就没有伟大的洞察力。

没有伟大的奋斗,就没有伟大的事业。

-->